以前の記事では、自然言語処理における事前学習と転移学習、そして、そのための手法としてBERTとGPTを紹介しました。

上記の記事で説明したように、GPT系列の中で、特に最新のGPT-3は、「人間らしい」文章を生成するなど、驚くほど高度なタスクを実行できます。しかしながら、GPT-3の利用に関しては社会的な問題とリソース的な問題が報告されています。本記事では代表的な課題を説明していきます。

GPT-3の活用に関する課題

■社会の安全に関する課題

GPT-3は、「人間らしい」文章を生成する可能性を保持しているゆえに、偽物のブログやスピーチの作成・発信に悪用されることが懸念されています。そのため、セキュリティを守るために、GPT-3は完全オープンソースとして提供されておらず、Open AIのAPIを介してのみ利用できるようになっています。また、このAPIの利用には申請が必要です。

https://openai.com/blog/openai-api/

■機能の限界

GPT-3は驚くほど高品質な記事を生成できるが、その記事の文法が正しくても、意味的に違和感や、文章の内容における矛盾を感じることが時々あります。また、GPT-3は「物理現象に関する推論」ができないことも指摘されています。例えば、「照明をつけたら眩しく感じますか」という質問には答えにくいです。

これらの問題は、GPT-3が前の文章にある単語との関係性を学習することには長けていますが、人間のような社会の慣習や常識を認識できないことに起因します。Part1で習ったシンボルグラウディング問題とも関連していますね。

■学習や運用のコスト

膨大なパラメータを使用したGPT-3の事前学習を現実的な時間内で実現するためには、非常に高性能なGPUを必要とします。逆に、最も低い市場価格のGPU環境を使用することを想定した場合、数百年かかってしまうと言われています!

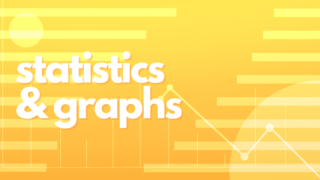

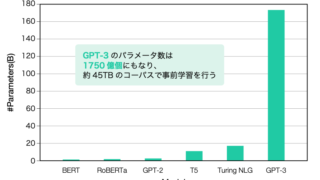

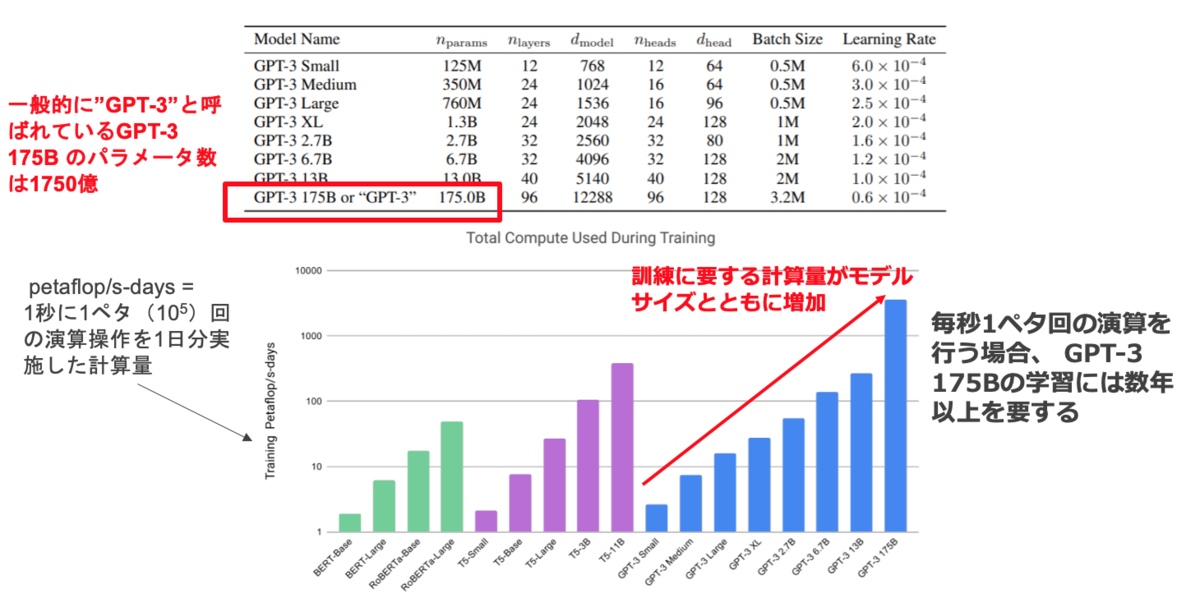

訓練に要する計算量(時間、リソース)は、モデルのサイズ(パラメータの数)とともにスケールします。下図からわかるように、毎秒1ペタ回の演算を行う場合、 GPT-3 175Bの学習には数年以上を要します。

GPT-3のモデル構造と計算量

表とチャートの出典:GPT-3原論文:「Language Models are Few-Shot Learners」; https://arxiv.org/abs/2005.14165

モデルサイズを含む自然言語処理モデルの課題に関しては、是非以下の記事もご覧になってください。

ここまで読んでいただきありがとうございました。それでは、次回またお会いしましょう。

記事担当:ヤン・ジャクリン(分析官・講師)