説明可能AI(Explaianble AI; XAI)に関する著名な論文として、以前は以下の論文を解説しました。

How does This Interaction Affect Me? Interpretable Attribution for Feature Interactions(筆者和訳:特徴量の相関関係を考慮できるモデル非依存型解釈手法)

今回解説するNeurIPSの論文は、以下です。

Neural Additive Models: Interpretable Machine Learning with Neural Nets

筆者和訳:ニューラルネットワークの線形加法モデルにおける解釈性

論文リンク:Neural Additive Models: Interpretable Machine Learning with Neural Nets

Part of Advances in Neural Information Processing Systems 33 (NeurIPS 2020)

著者:Rishabh Agarwal, Levi Melnick, Nicholas Frosst, Xuezhou Zhang, Ben Lengerich, Rich Caruana, Geoffrey E. Hinton

研究の目的

ディープニューラルネットワーク(Deep Neural Network; DNN)は幅広いタスクにおいて高い予測能力を発揮する代わりに解釈性を代償にしています。予測の根拠の説明が難しいゆえに、今でもニューラルネットワークを高リスク分野に使うことがためらわれています。

本論文では、ニューラルネットワークの精度を維持しながらブラックボックス問題を解消する目的で、Neural Additive Models(NAMs)が提案されています。

NAMsの仕組み

NAMは実際、GAM(Generalized linear models; 一般化線形モデル)の一種と解釈することができます。GAMには線形回帰、ポアソン回帰、ロジスティック回帰などが含まれます。線形モデルは比較的に解釈性に優れています。一方で、どうしても単純な線形モデルの予測精度はニューラルネットワークにかないません。

そこでNAMは、高い表現力を持つDNNをよりシンプルな線形モデルと組み合わせることで、高い精度と解釈性を両方実現しようとしています。いわゆる「スタッキング学習器」の一種です。

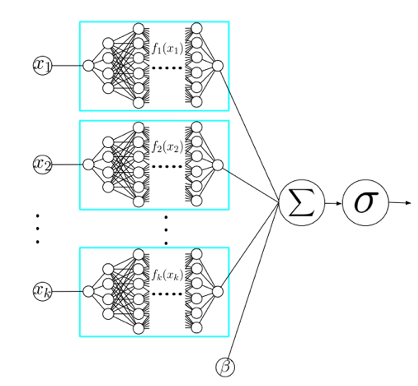

具体的に、NAMsはニューラルネットワークの線形結合で構成されています。下図のように、1つの入力特徴量には専属のニューラルネットワークが1つ割り当てられており、全てのネットワークが同時に学習されます。

NAMsはニューラルネットワークの加法モデルです。入力変数(特徴量)のそれぞれが専用のニューラルネットワークに担当されている構造をしている。 (論文より抽出)

NAMsはニューラルネットワークの加法モデルです。入力変数(特徴量)のそれぞれが専用のニューラルネットワークに担当されている構造をしている。 (論文より抽出)

NAMの性能は回帰問題と分類問題の両方で検証されています。その結果、予測精度は従来のロジスティック回帰木と決定木などの弱学習器より優れており、かつ、一般的な加法モデル(スタッキングやアンサンブル学習器)と同程度です。つまり、NAMsは従来の高精度モデルに予測精度や表現力が一切劣らないと同時に、解釈性の面では優れています。

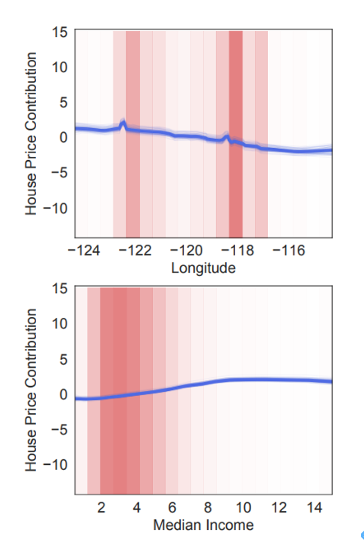

下図には、NAMsを用いた家賃予測モデルの解釈が示されています。

NAMsによって家賃予測モデルの解釈。ここでは2つの最も寄与が顕著なパラメータが上の”longitude” (経度)と下の”median income” (該当地域の世帯収入の中央値)であることが判明されています。この結果から、データが密集する地域では、家賃は”median income”とともに線形的に増加します。経度による変化を見ると、サンフランシスコとロサンゼルスに対応する位置で家賃が跳ね上がることも判明されています。(論文より抽出)

NAMsによって家賃予測モデルの解釈。ここでは2つの最も寄与が顕著なパラメータが上の”longitude” (経度)と下の”median income” (該当地域の世帯収入の中央値)であることが判明されています。この結果から、データが密集する地域では、家賃は”median income”とともに線形的に増加します。経度による変化を見ると、サンフランシスコとロサンゼルスに対応する位置で家賃が跳ね上がることも判明されています。(論文より抽出)

性能試験:COMPAS recidivism dataを使ったテスト

NAMsの代表的なテストには、著名なCOMPAS recidivism data を使ったものが挙げられます。COMPAとは “Correctional Offender Management Profiling for Alternative Sanctions” の略です。これはNorthpointe社によって提供されているアルゴリズムであり、米国では裁判官や警察が再犯率をスコアリングするのに使われています。再犯率が高めの受刑者には厳しい刑を科すように判断します。このAIアルゴリズムは一人の人生へのインパクトが非常に大きいにもかかわらず、ブラックボックスになっています。再犯率を予測する因子が十分に明らかにされていないことが問題視されています。

予測に効く因子を解明するために、従来ではLIMEがよく用いられていました。しかし先述の通り、LIMEは線形モデルを用いた近似を通じて単独のサンプルに対する局所的な解釈に特化しています。それに対して、今回のNAMsはモデル全体の振る舞いを理解させる効果があります。

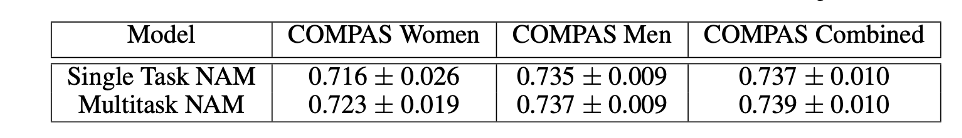

NAMsのもう1つの強みは、マルチタスク学習(multi-task learning)に発展させることができることです。1つの特徴量に対して複数のサブ・ネットワークを学習させることです。最終的なアウトプット結果は、全てのモデルの結果に重み付けしたものを加算した結果が採用されます。下表には、COMPASデータセットに対するNAMsの予測精度(single taskとmulti-task learningの両方)を、ROCの下の面積に対するAUCで評価したものです。男女のどちらに対しても7割程度の精度を達成していることがわかります。

COMPASデータセットに対するNAMsの予測精度(論文より抽出)

COMPASデータセットに対するNAMsの予測精度(論文より抽出)NAMsの解釈性が高いために、上記の再犯率の例以外にも様々な高リスクの応用が考えられます。例えば、医療AIにおいて、COVID-19の判断を下す解釈可能なモデルを実現できています。

(参考)COMPAS に関するXAIのケーススタディ:https://pbiecek.github.io/xai_stories/story-compas.html