前回はこちらで、日常生活における統計学の大切さとデータサイエンティストにとっての統計学の大切さを話しました。

今回は、「統計分析」の概要と他のデータ分析手法との関連性について話します。

そして、次回のPart3では、事例を紹介します。

統計分析とは

「統計分析」という言葉をよく聞くけど、統計分析とは何か、他の分析手法とはどう違うのかを見ていきましょう。

統計分析とは、統計学の分析フレームワークにあてはめてデータを処理し分析する手法です。手元にある、ばらつきのある大量のデータを材料とします。そのデータから、統計学の理論にもとづいて処理を行うことで、数値上の性質や規則性を明らかにし、さらに多角的な視点で仮説を立てて、その仮説の正しさを検証するような分析です。

昔から確立された学問分野の理論体系に沿って、データ分析の各プロセスが論理的に、人間にわかりやすい手段で実行されています。そのため、統計分析を通じて得られた結果は、ビジネスの施策立案に使いやすく、意思決定を行う上で大切な判断材料や根拠になります。統計分析は今まで「勘」や経験則で行ってきた意思決定を、より信頼性の高いものにしてくれます。

統計分析の種別

統計学の理論を用いて行う統計分析は、2つの主要カテゴリーに分けることができます。

1.記述統計学(descriptive statistics)

データの特徴や傾向をわかりやすく・直感的に説明することを目指します。データを整理し、基礎統計量(平均や分散など)を算出し、データを表やグラフの形で可視化します。

具体例としては、「社員の年収の平均とばらつきの算出」や「全国学力統一試験の結果から偏差値の算出」などが挙げられます。

2.推測統計学(inferential statistics)

データ全体(母集団)から一部(標本)を抜き出して、その標本の特性を調査することで母集団全体の特性を推測します。さらにその推測が正しいかどうかを検定します。確率の考え方を土台にしています。推計統計学とも呼ばれます。

統計分析と他の分析手法

自然科学や社会科学の研究、およびビジネスの世界ではデータ分析は長年、統計学を駆使して行われてきました。

今日、Python や R などのオープンソースプログラミング言語を用いた機械学習や、BIツールを用いた可視化分析など、さまざまなデータ分析手法が使われるようになりました。どの手法を選ぶかは、分析担当者が持つスキルにも依存します。例えばマーケティング担当者が分析する場合、機械学習よりも、Excel を用いた統計分析やマウス操作だけで分析を行える「セルフサービス型 BI ツール」を先に検討するかもしれません。

これらの分析手法を用いて出力した分析結果を解釈し評価する際にも統計学が役に立ちます。実は、われわれが「分析の手段」や「分析のツール」として呼んでいるものの多くは、実は(少なくとも一部は)統計分析を用いています。また、機械学習の手法や理論は、統計学に基づいた従来の分析手法の延長上に発展してきたのです。

統計分析と機械学習の比較

ビッグデータの分析に関して、「機械学習」がよく取り上げられます。ここでは、統計分析と機械学習がどう違うのか、どちらを選べば良いのかについて考えましょう。

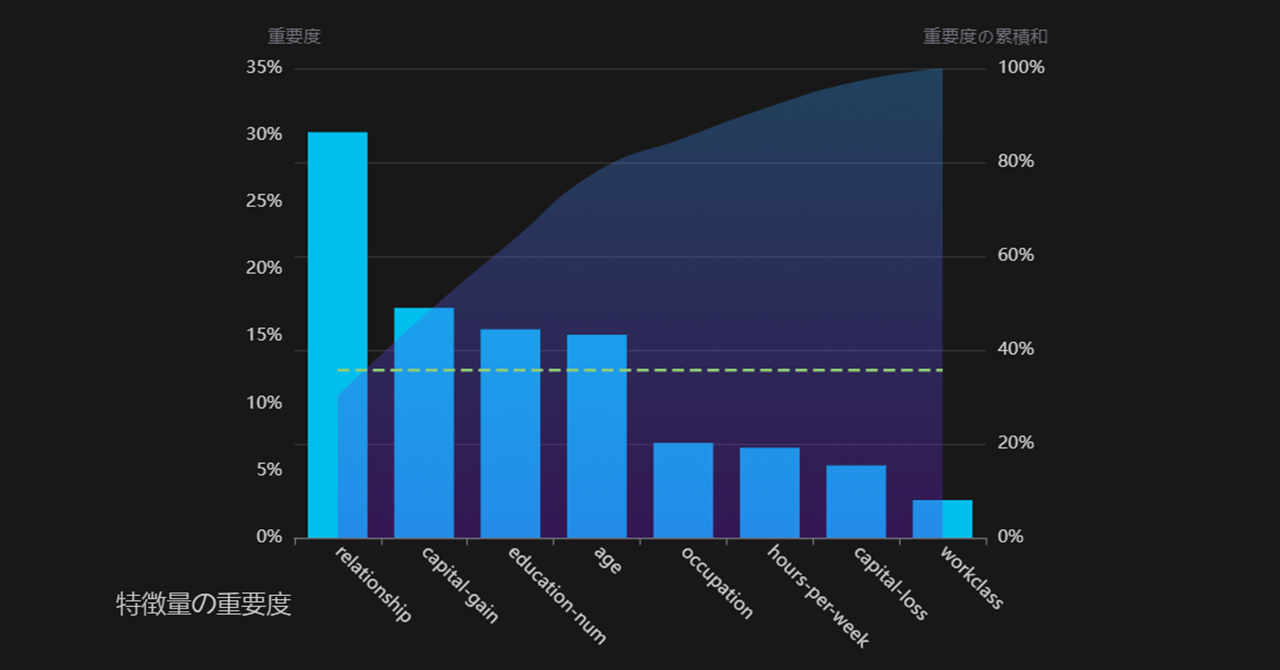

機械学習とは人工知能(AI)の1つの分野として発展してきました。機械学習の代表的な手法として、売上分析によく使われる決定木またはそのアンサンブル学習器であるランダムフォレスト、サポートベクトルマシン、ニューラルネットワークなどが挙げられます。

機械学習では、データに潜む特徴を見つけ、それらを軸にして機械学習のモデルを学習させます。データから汎用的な法則やパターンを自動的に見いだせることを目標に学習が行われます。学習済みモデルには、答えが未知のデータに対して、学習済みモデルが十分に高い精度で予測できることが期待されます。人間が学習のプロセスに直接関わらなくても、それなりに精度の高い予測ができるのが機械学習の特徴です。

機械学習と統計分析手法の本質的な違いはその「戦略」と「目的」にあります。

・機械学習の手法は予測精度を重視

・統計分析の手法はモデルの解釈を重視

《統計分析は解釈性を大切にする》

統計学で大切にすることは、可視化や統計量の計算を通じて、データの性質、構造、傾向を解釈しやすくすることです。そのため、統計分析のモデルは比較的シンプルでわかりやすいものが多いのです。少なくとも機械学習のアルゴリズムほど複雑ではありません。例えば、広く使われている統計分析の一種である「線形回帰」に関して、回帰分析モデルのパラメータである回帰係数が示す意味がわかりやすいと実感していただけるでしょう。また変数間の相関関係も直感的に理解しやすい分析です。

また、統計学の理論に基づいて行われるため、分析のプロセスと結果を、しっかりと科学的根拠をもって説明できます。統計学では「こういう関係性だと辻褄が合うのではないか」という仮説をあらかじめ立て、そこにデータをあてはめ、仮説の妥当性を検証します。モデルの内部構造そのものに関心があり、論理的に説明できるようにならないといけません。

《機械学習は予測精度を大切にする》

機械学習手法はとにかく高い予測精度を出せることに一筋です。これを達成するために、統計分析よりも複雑かつ難解なアルゴリズムを用います。また、高い予測精度さえ出せれば、モデルの整合性をさほど気にしません。そういう意味で、さまざまなデータやモデルを自由に組み合わせての使用も許されます。言い換えると、解釈しやすさや透明性を犠牲にしても、精度を少しでも上げていきたいというのが機械学習の姿勢です。

《統計分析はデータ量がやや少なくても使える》

統計分析でも機械学習でも「データは多ければ多いほど良い」というのは事実です。一方で、統計学の手法は、比較的少ないデータに対しても適用できる手法が多いです。これは、統計モデルの構造がシンプルであることとも関係しています。

コンピューターというものが存在しなかった昔の時代から、既に統計分析が使用されていました。当時はそもそも手動で収集・計算できるような有限のサンプルしか扱いませんでした。手計算で扱えるデータ量は多くても数百、数千件ほどです。数百件のデータが手元にあり、かつデータの分布に関する仮定を満たせば、統計学に基づいた推論を行うことが可能です。

《機械学習は大量なデータを扱うのが得意》

前述の通り、機械学習では大量なデータを用いて汎用的な法則を学習し、高精度な学習済みモデルを目指しています。比較的大きなデータを扱うからこそ、機械学習はビッグデータの時代とともに勢力が増してきました。

実際にどれほどデータ量が必要かは、使用するアルゴリズムによって異なります。比較的シンプルな決定木モデルは数百件のデータでもモデルを構築できるケースがあります。一方で、画像認識や自然言語処理が得意なニューラルネットワーク(ディープラーニング)は、その複雑なモデル構造ゆえに、ゼロから訓練するためには一般的に数百万件から数億件のデータが必要です。

■統計分析を選ぶ場面

統計分析のプロセスと結果が機械学習に比べて解釈しやすい傾向にあります。したがって、「わかりやすさ」の観点からいうと、分析のプロセスを同僚やクライアントに説明・提案する必要がある場合、統計学的なアプローチが有利である可能性があります。実際、「人間が解釈できる」という要請があるビジネスの場面では、最先端の機械学習の手法よりも、昔から安心して使われてきた統計分析が採用されることがあります。また、大量なデータを確保できない場合でも、統計分析が選択されます。

■機械学習を選ぶ場面

機械学習の手法を用いる場合、アルゴリズムの複雑な構造の内部パラメータに大量のデータの情報を反映でき、人間が気づけないような新しい発見を導き出すことができます。したがって、機械学習の分析手法は、データを十分用意できて、説明可能性や人間の介入が求められず、予測精度と自動化と高速化が重視される場面で選ばれます。例えば、ウェブ記事のレコメンドや広告最適化などの低リスク分野は、ロジックが多少複雑で難解であっても、高精度さえ示されていれば使って問題がないと判断されます。