MIT Technology Reviewの記事で、海外で「龍が如く」の「ばかみたい」をDeepFakeで画像から勝手に口パクさせるのが流行ってるとのことで、Kapwing Appさんのチュートリアルにしたがって、やってみました。

できたもの

Baka Mitai/Dame Da Neつくってみた

この動画を作るのは1時間半くらいかかりましたが、実際の作業は数分で完成します。

DeepFakeのソース画像、Driving動画、アニメーションされた動画

ソース画像は動きのない画像(左)で、それをDriving動画(真ん中)に合わせて、無理やり画像をアニメーション化させること(右)を機械学習によって行います。

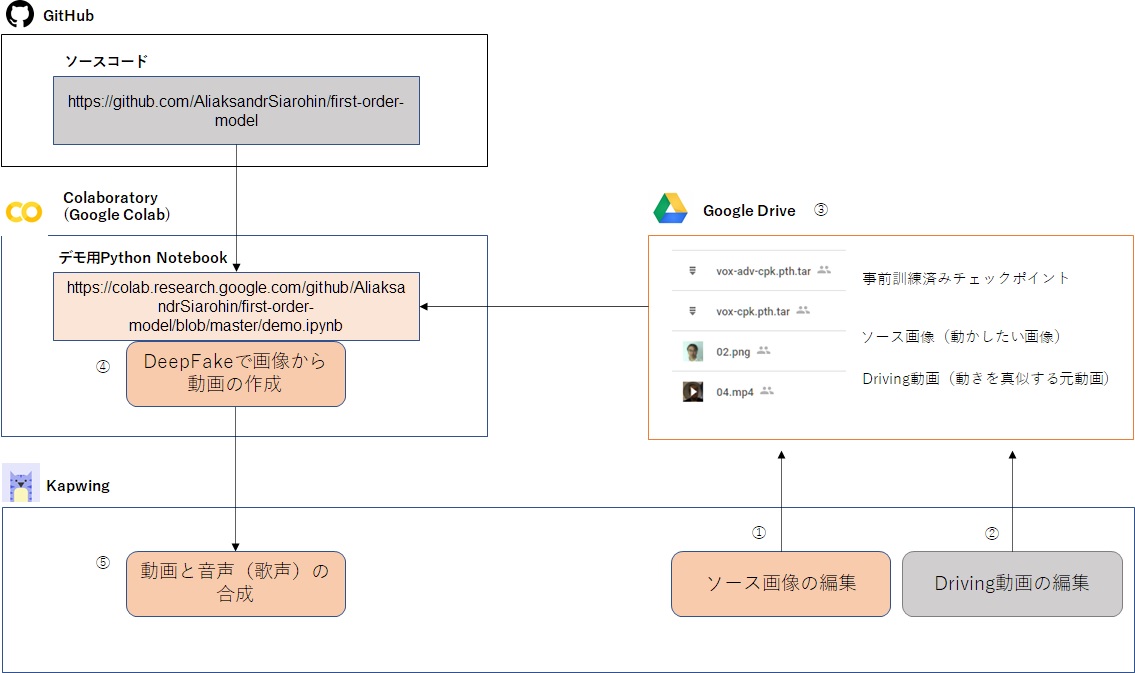

構成図

チュートリアルに従って作ってみたときの構成図です。メインで使うのはColaboratory上のPython Notebookです、これはAliaksandrSiarohinさんが用意したデモ用のノートブックで、これをポチポチとボタンを押していきます(コーディングをしなくてもデモで自分用の動画を作れます)。コードはAliaksandrSiarohinのGitからcloneさせます。自分で動画を作るためのソース画像(動かしたい画像)、Driving動画(動きを真似する元動画)、チェックポイントファイル(顔の特徴点の関係性を定義した訓練済みデータ)をGoogle Drive上に入れます。なお、今回の時間の大半は1時間20分くらいは、このチェックポイントファイルをニュージーランドのファイル共有サービスから持ってくるのに時間がかかりました(700MBくらいのファイル2つ)。もしかしたら、AliaksandrSiarohinさんのドライブから持ってきたら、もっと速いかもです。また、画像、動画の編集などはオンラインで使えるKapwingを使いました。

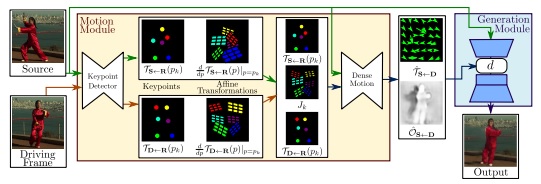

元となっている論文(First Order Motion Model for Image Animation)

この論文で提案されているアルゴリズムは、従来のkeypointのアノテーションを大量に必要とするアルゴリズムと異なり、対象物の事前知識なしに使えるところが、手軽に使える点です。

元となっているモノマネ動画

Lip Sync Shun Akiyama Baka Mitai (Yakuza)

動きを真似するための元動画は、こちらのDobbsyrulesさんのモノマネ動画です。龍が如くの歌マネが、なぜ海外で流行っているか分からないのですが、めっちゃ面白いです。

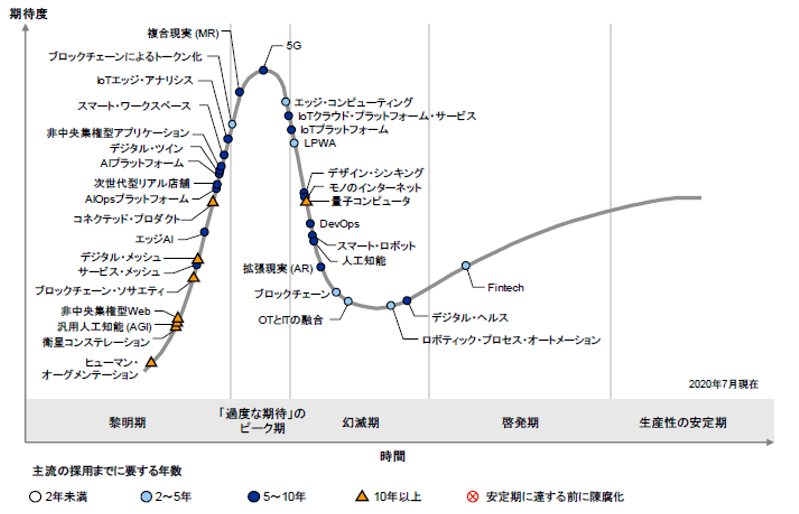

全体として

Deep Learningの訓練などがとても大変な作業ですが、ある範囲のアウトプットに限定させるAIプラットフォームが用意できるならば、手軽に利用することが分かりました。GartnerのHypeサイクルに見られる、黎明期にあるAIプラットフォームのタネは、こういうものを組み合わせたものなのだろうと思います。

古幡征史